第四周

深度神经网络

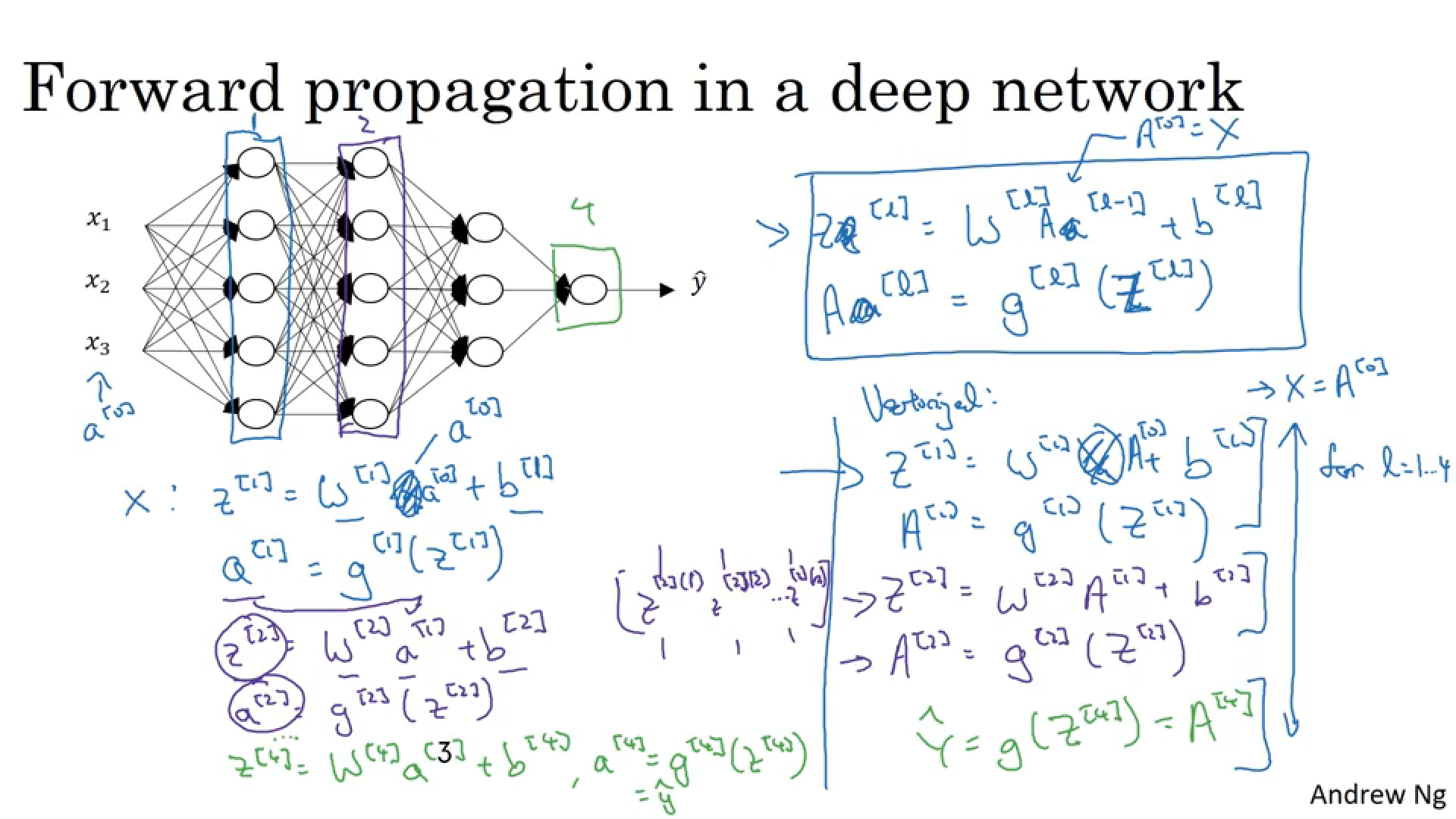

上面这张图清晰的反映了多层神经网络的形态,以及参数的流动,首先是第一个隐藏层,它的输出是A1,同时这个A1又作为了第二个隐藏层的输入,从而达到了不断学习的能力。神经网络的维度

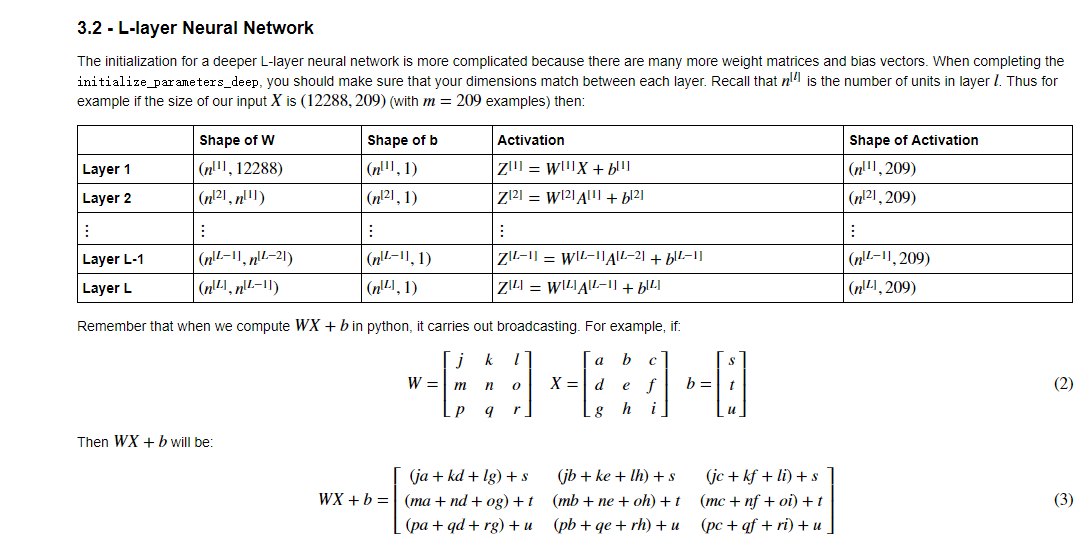

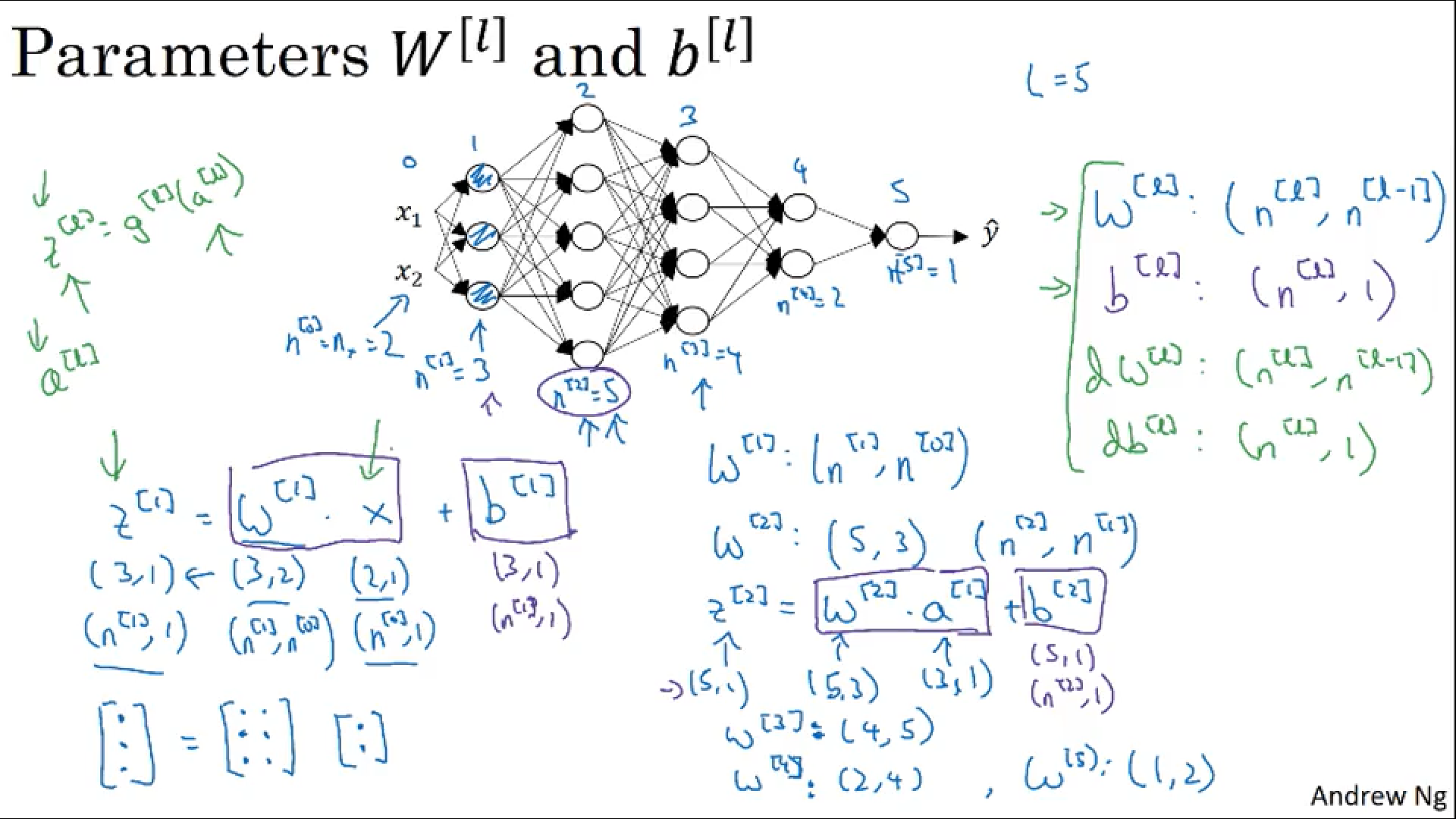

在深度神经网络的训练中,非常重要的一点就是保障矩阵的维度处于你所想要的状态,比如在逻辑回归Z=WX+B这个方程中,我们能确定的东西有X,因为它是输入层,所以自然能够知道其维度,再就是Z的维度,因为Z是输出层,我们想要获得一个怎样的输出,这个也是人为设计的,那么在这个例子中,不清楚的维度就是两个需要训练的参数,W和B。我们先来研究W的维度,为了满足矩阵的运算方法(此处为点乘),我们可以推出W的维度,比如Z为(3,1),X为(2,1),那么W的维度自然是(3,2),如果不是(3,2)则无法进行矩阵操作,然后再通过Z的维度确定B的维度,因为要完成相加操作,所以B的维度应该与Z相同。然后上面的图中给出了如下的快速检查方法,那就是W[l]的维度是(n[l],n[l-1]),其中这里的n代表的是深度网络中的第n层的维数,这个数据也在上图中有说明,其他维度也可以参考图上所描述的进行检查。神经网络的前向传播和反向传播

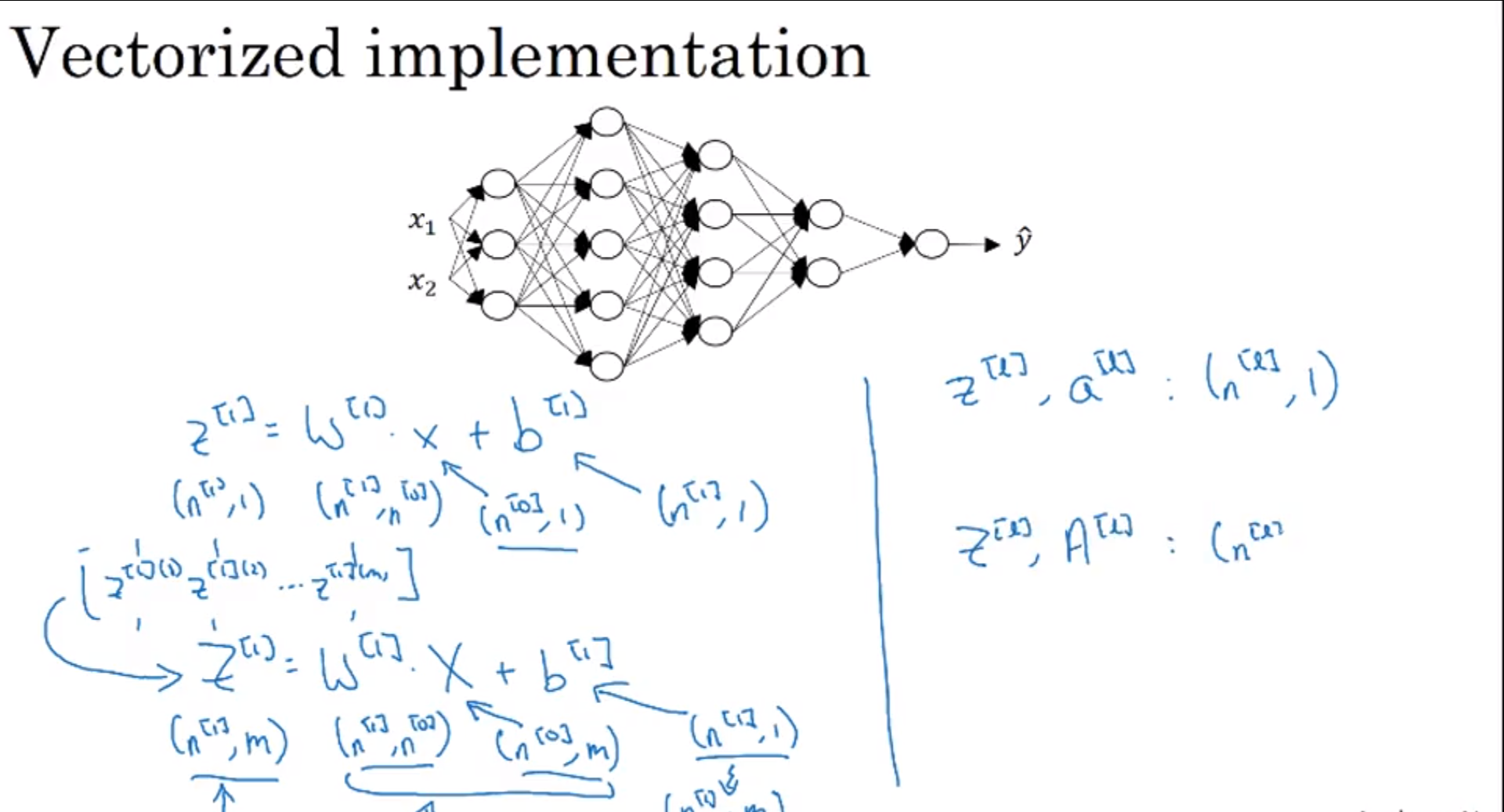

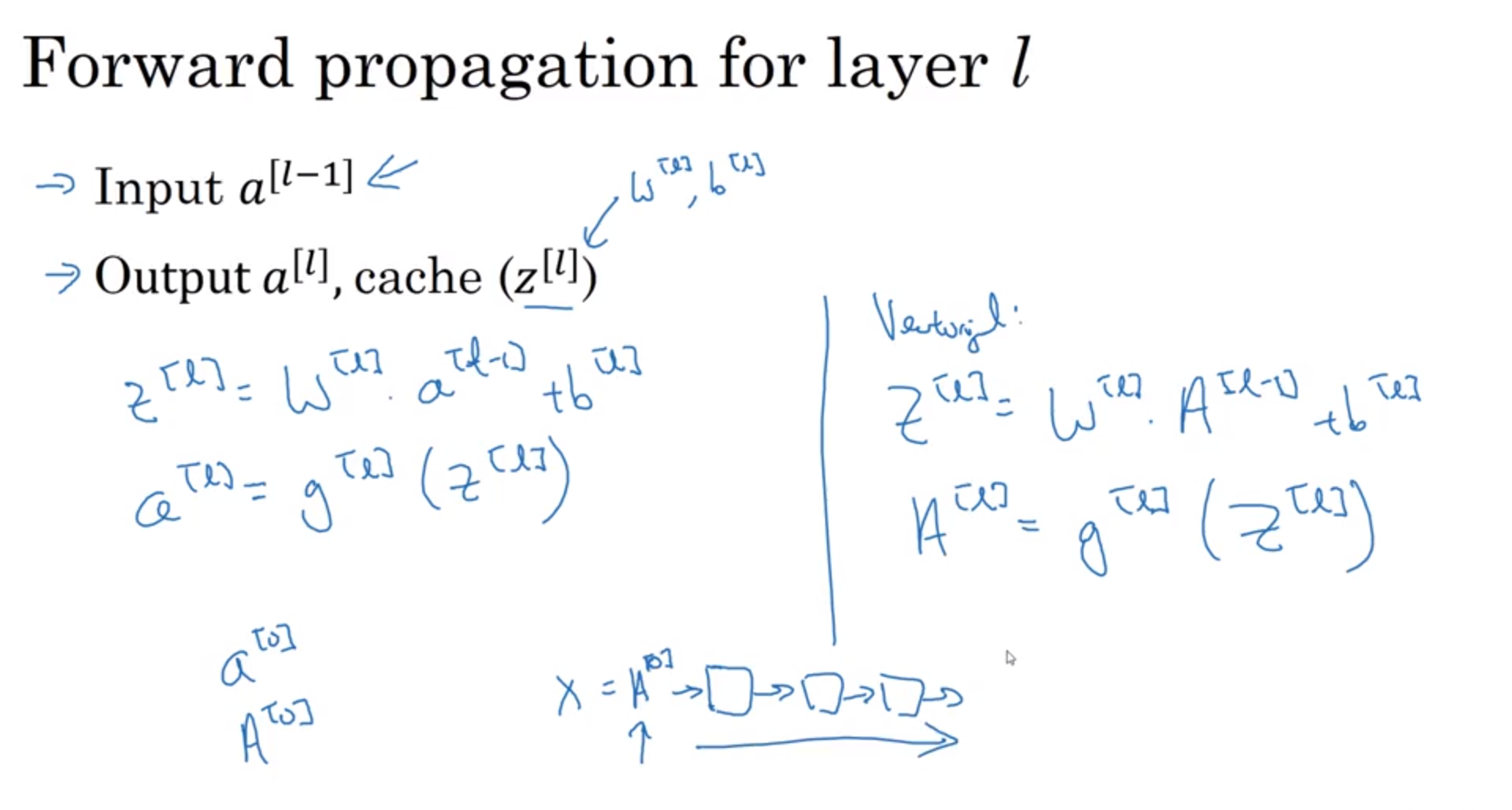

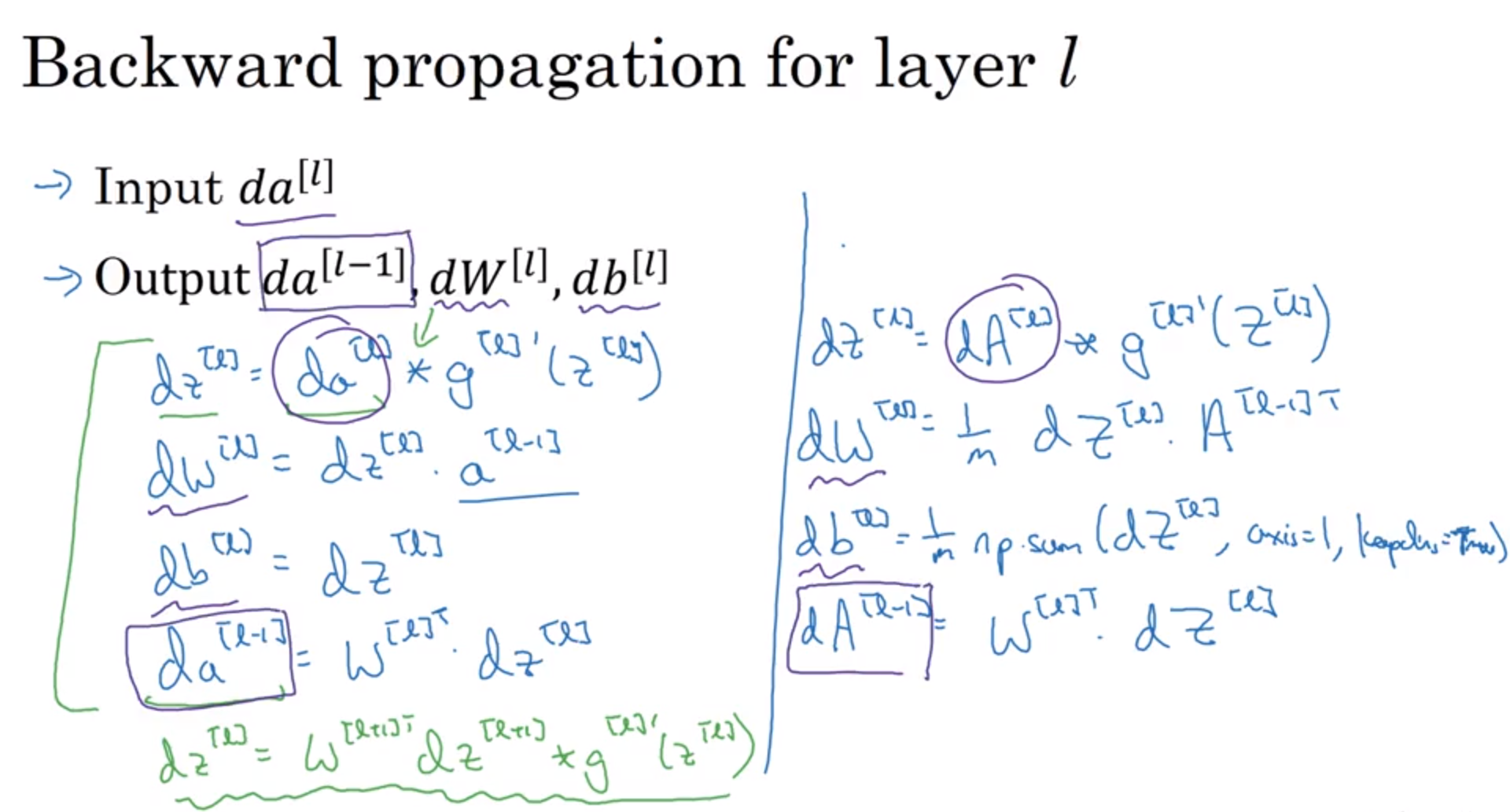

上面的两个图总结了神经网络在进行前向传播和反向传播的过程中所运用的数学公式和方法。

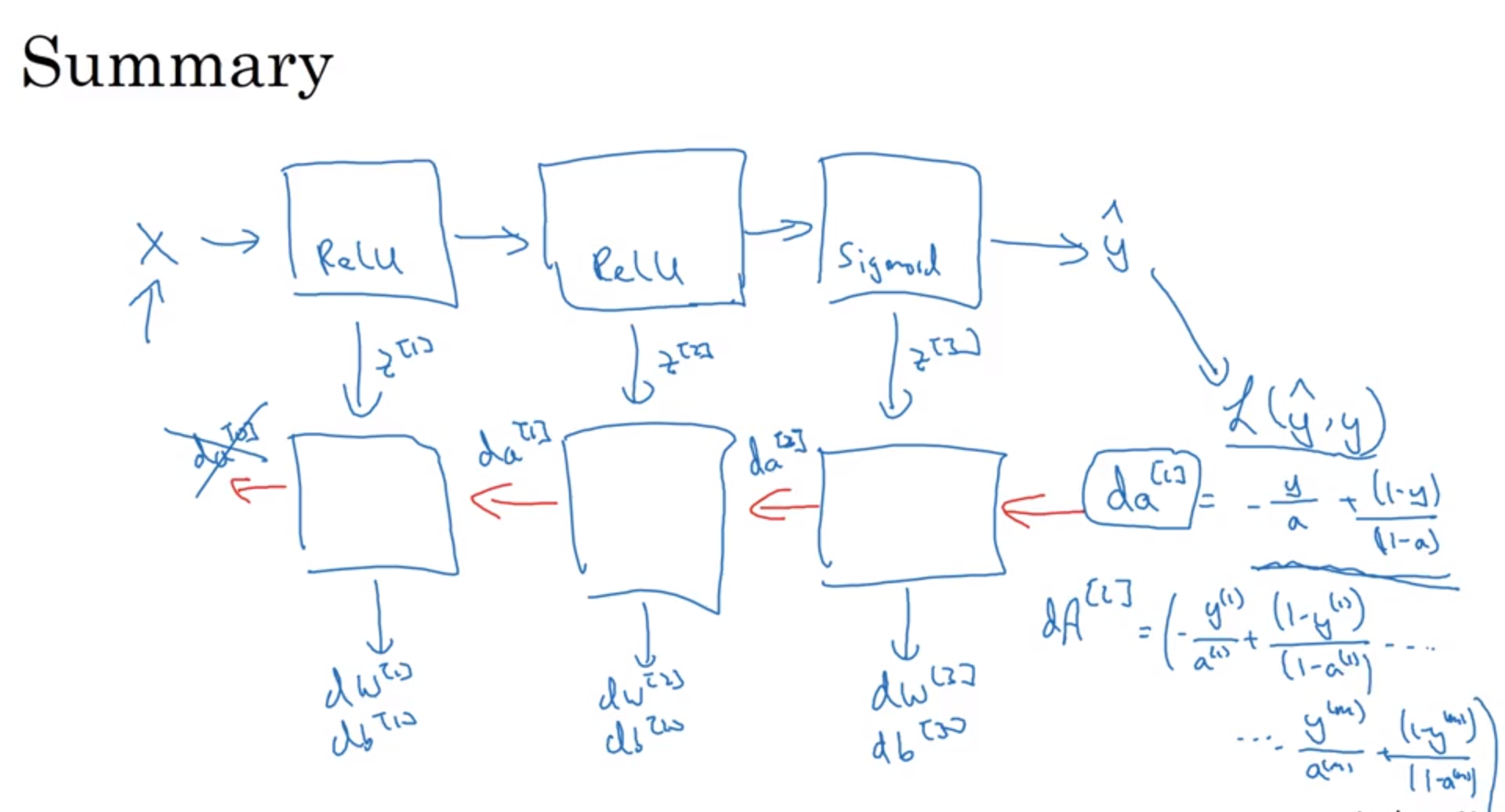

这个总结图完整的展示了神经网络的计算过程,从输入X到前向传播以计算出损失函数,然后再反向传播求的参数以达到不断训练的目的。参数和超参数(hyperparameters)

在神经网络中,我们经常使用到的参数是w和b。而在整个学习算法中,我们还会使用到学习率α、迭代次数、隐藏层、神经单元以及激活函数等等东西。以上这些因素都会影响到w和b的计算,所以把以上的参数称之为超参数。